Erfahrungen mit KI-Bildgeneratoren: Experimente mit Stable Diffusion

Künstliche Intelligenz (KI) ist seit November letzten Jahres nicht mehr aus der Welt wegzudenken und revolutioniert auch den Umgang mit Kunst und Design. KI-Bildgeneratoren, insbesondere Diffusionsmodelle wie Stable Diffusion oder Midjourney, haben die Möglichkeit eröffnet, Bilder auf eine Art und Weise zu erzeugen, die zuvor undenkbar war.

Stable Diffusion, Midjourney und Co.

Stable Diffusion, Midjourney oder auch Dall-E sind Datenmodelle, die den Zufallsprozess der Diffusion nutzen, um Schritt für Schritt Bilder zu erzeugen. Auf die Funktionsweise gehe ich hier nicht näher ein. Es gibt einige gute Videos oder Blog-Beiträge darüber, wie Diffusionsmodelle funktionieren, wie z.B. dieser von Jay Allamar, aber es wird sehr schnell sehr komplex.

Die verschiedenen Dienste funktionieren ähnlich, unterscheiden sich aber in der Handhabung. Midjourney ist auf einem Discord-Server gegen Gebühr nutzbar. Die Eingabe funktioniert über Text. Optional können bis zu zwei Bild-Inputs mitgegeben werden und so zum Beispiel zusammen gemischt werden.

Stable Diffusion Stable Diffusion hingegen ist Open Source und kann - eine leistungsfähige Grafikkarte vorausgesetzt - kostenlos und lokal betrieben werden. Mit ein wenig Know-How als Webentwickler kann über das Terminal ein Webinterface für Stable Diffusion installiert werden, wo neben Textprompts verschiedene Einstellungen vorgenommen werden können. Nach einem mehrstündigen Selbststudium konnte es losgehen.

Gold Boy und Rocksteady Queen

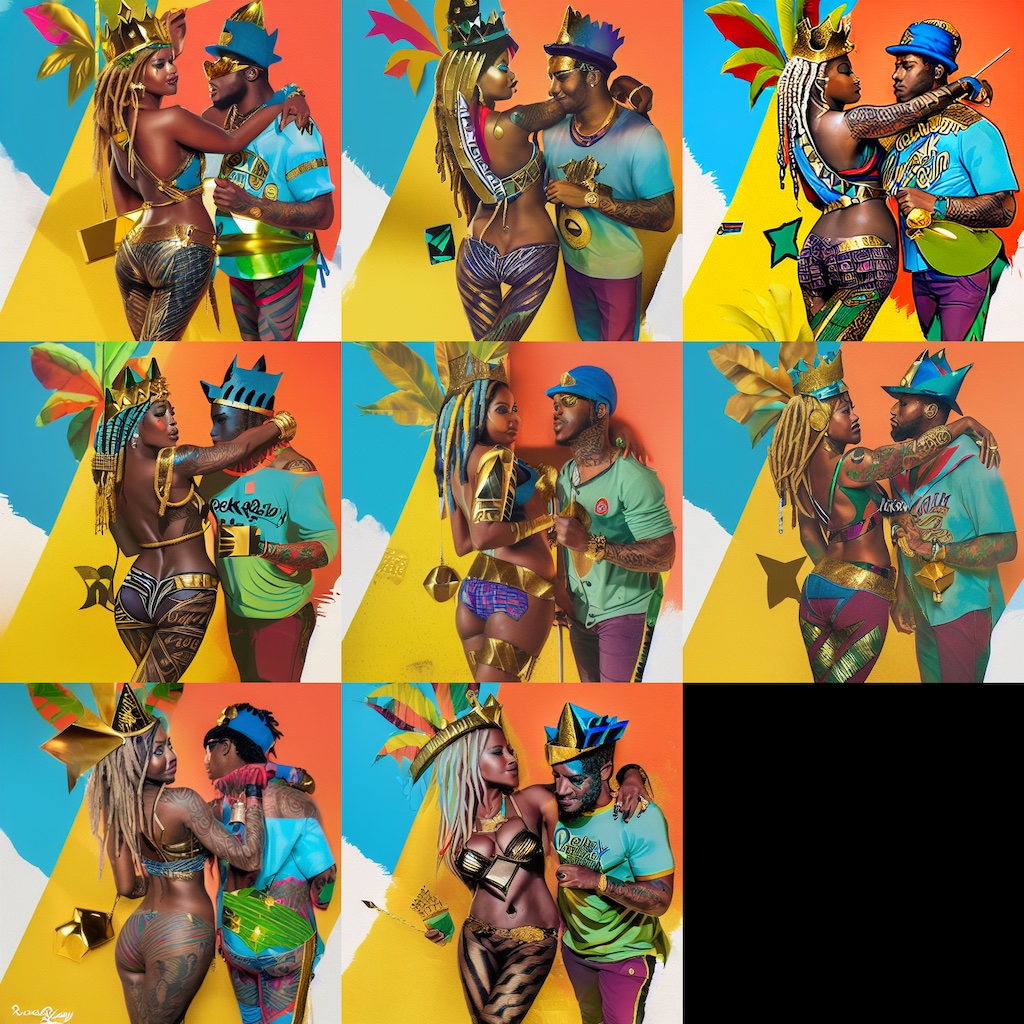

Die erste Idee für ein Experiment mit Stable Diffusion kam mir irgendwann beim Musikhören. Der Song "Hale-Bopp" von Seeed, genauer gesagt die Zeile «Wir sind ein wunderschönes Team, Gold Boy und Rocksteady Queen», inspirierte mich zu einer Illustration.

Erster Prompt

Am Anfang wollte ich es nicht zu kompliziert machen. Ich schrieb einen einfachen Prompt und liess sechs verschiedene Kompositionen generieren.

Prompt:

rocksteady queen and goldboy, illustration, artwork, vibrant colors, graffiti style, creative details, masterpiece, high quality details, 8k

Prompt verfeinern

Mit einer Bildkomposition, die mir gefällt, kann ich nun in den img2img-Modus wechseln. Dort wird das Bild als Ausgangspunkt genommen. Mit einem Schieberegler kann das Bild oder der Text stärker gewichtet werden.

Prompt:

(rocksteady queen and goldboy:1.6), banana leafs, rasta, tattoo, t-shirt and jeans, illustration artwork, vibrant colors, grafiti, creative details, surreal lighting, masterpiece, high quality details, 8k

Inpainting

Interessant wird es, wenn man mit einer Bildkomposition zum nächsten Modus übergeht, dem Inpainting.

Hier simuliert Stable Diffusion einen zufälligen Prozess, bei dem ein Bild oder ein maskierter Teil des Bildes nach und nach durch Hinzufügen von Rauschen zerlegt und wieder zusammengesetzt wird. Beim Inpainting verwendet das Modell den umgebenden Kontext, um den fehlenden Teil zu rekonstruieren.

Auf diese Weise können bestimmte Teile des Bildes, z. B. die rechte Hand auf der Schulter, verändert werden. Der Rest des Bildes bleibt unverändert.

Dabei ist zu beachten, dass jeder neue Prompt die Grafikkarte stark auslastet. Je nach Grafikkarte kann dies mehr oder weniger Zeit in Anspruch nehmen.

Fancy Portrait-Bild für LinkedIn

Ich wollte auch ein Porträt von mir machen lassen. Dazu musste ich aber zuerst ein eigenes Bildmodell mit ca. 30 Fotos von mir trainieren. Mit dem entsprechenden Bildmodell und dem trainierten Schlüsselwort kann dann mein Gesicht generiert werden.

Interessant ist dabei, wie das Modell je nach Einstellung völlig am Ziel vorbeischiesst.

Dann aber, nach Verfeinerung der Einstellungen (und x Versuchen) kommen auch gute Bilder heraus.

Die Grenzen der Technologie

Obwohl Stable Diffusion beeindruckende Ergebnisse liefert und sehr viel Spass macht, hat die Technologie ihre Grenzen. Manchmal sind Ergebnisse ohne Verfeinerung einfach nur schlecht.

Was mir am meisten aufgefallen ist, ist die Schwierigkeit, den Workflow entsprechend dem gewünschten Ergebnis zu beherrschen. Wenn man ein bestimmtes Bild im Kopf hat, kann es schwierig sein, es genau so zu erzeugen.

Darüber hinaus kann der Prozess sehr zeit- und ressourcenintensiv sein, insbesondere wenn man nicht über die neueste (und teure) Grafikkarte verfügt. Wenn man mehrere Bildkompositionen erstellen möchte – was sich gerade am Anfang des Prozesses empfiehlt – kann die Wartezeit schnell zur Geduldsprobe werden. Besonders frustrierend ist es dann, wenn nach langem Warten die erzeugten Bilder nicht den Erwartungen entsprechen.

Trotz aller Herausforderungen ist das Experimentieren mit Stable Diffusion faszinierend, durchaus unterhaltsam und manchmal ein bisschen spooky.

Hast du auch Erfahrungen mit Diffusionsmodellen gemacht, oder hast du eine Frage?